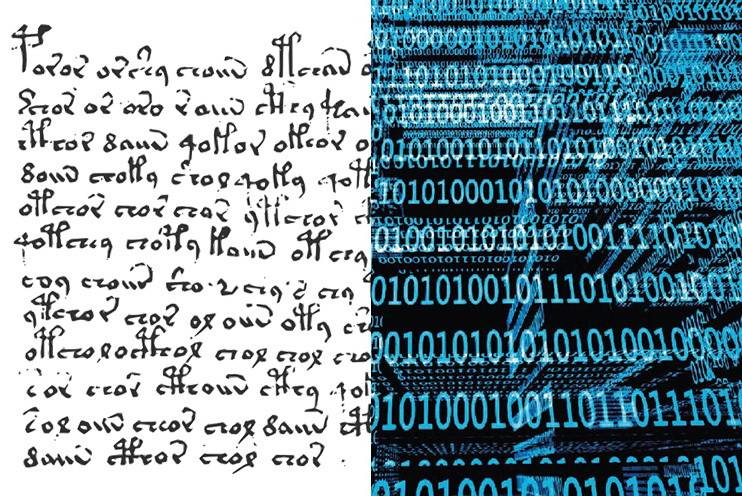

Kryptographie, allein das Wort klingt schon geheimnisvoll und beschreibt die Wissenschaft der Verschlüsselung. Passionierte Leser und Kinogänger denken schnell an den US-amerikanischen Thrillerautor Dan Brown und seinen Helden, den Symbolforscher Robert Langdon, der die Geheimnisse codierter Schriften für uns Laien verständlich zugänglich macht.

Nicht ganz so einfach, aber ebenso spannend arbeiten Forscherinnen und Forscher verschiedener Disziplinen an der Bergischen Universität sowohl an verschlüsselten historischen Texten als auch an moderner Informationssicherheit. Gemeinsam ist allen Wissenschaftlern dabei die Entdeckung codierter Informationen und deren gleichzeitiger Schutz. In dieser interdisziplinären Kooperation finden sich erstmals Historiker und Informatiker der Bergischen Universität zusammen und stellen fest, dass sie sich gegenseitig in ihren Forschungen helfen können.

Ein chiffrierter Zufallsfund war der Beginn

Dr. Jessika Nowak, Mitarbeiterin in der Mittelalterlichen Geschichte, stieß bei Recherchen für ihre Dissertation über einen italienischen Kardinal des 15. Jahrhunderts im Mailänder Archivio di Stato auf chiffrierte Gesandtschaftsberichte. „Es waren Schreiben, die gänzlich oder in Teilen chiffriert waren“, sagt die Wissenschaftlerin, „in wenigen Fällen hatte man das Glück, dass Zeitgenossen schon entsprechende Entschlüsselungen vorgenommen hatten, hin und wieder waren auch die ursprünglichen, noch nicht codierten Entwürfe der Schreiben erhalten, und manchmal gab es Schlüssel, die überliefert worden sind, so, dass man rekonstruieren konnte, was in diesen Passagen gestanden hat.“

Meistens jedoch seien die Verschlüsselungen sehr komplex und elaboriert und die entsprechenden Abschnitte für Historiker oft unlesbar. Der Kontakt mit den Informatikerkollegen Prof. Dr.-Ing. Tibor Jager, Dr.-Ing. Kai Gellert, Jonas von der Heyden sowie dem Leiter des Faches Digital Humanities, Prof. Dr. Patrick Sahle, dessen Arbeit eine Art Schnittmenge zwischen der Geisteswissenschaft und der Informatik bildet, eröffnete ihr dazu auf einmal neue Möglichkeiten.

Wo kommen Geheimsprachen her?

Schon im alten Ägypten gab es nachweislich verschlüsselte Texte, die eine Gottheit beschrieben, die nicht mehr genannt werden durfte, und ein Töpfer aus Mesopotamien chiffrierte ca. 1500 v. Chr. seine Glasuren, um sich vor Ideenklau zu schützen. Auch die Spartaner hatten im 5. Jahrhundert. v. Chr. schon eine pfiffige Geheimsprache entwickelt. Auf einem Lederband, welches man um einen Stab wickelte, wurden militärische Botschaften überbracht. Nur wer einen Stab gleichen Durchmessers hatte, konnte beim Aufspulen des Lederbandes die richtigen Informationen erhalten.

Caesar benutze beispielsweise zwei aufeinanderliegende Scheiben mit dem lateinischen Alphabet, die man zueinander drehen musste, um die richtige Information zu erhalten, Karl der Große tauschte sich mit seinen Generälen durch Geheimcodes aus, und Hildegard von Bingen ist sogar die älteste bekannte mittelalterliche Prominente, die mit der Lingua Ignota eine Geheimschrift entwarf, die magischen Zwecken dienen sollte.

„Bei der klassischen Cäsar-Chiffre ist es so, dass jeder Buchstabe in der Verschlüsselung durch den Buchstaben ersetzt wird, der drei Stellen weiter hinten im Alphabet steht“, erklärt Nowak. „Ähnliche Substitutionen kennt man auch aus dem Mittelalter. Es werden also Buchstaben einfach anders angeordnet oder aber z.B. die Vokale durch eine auf- oder absteigende Anzahl von Punkten ersetzt. Vokale werden auch durch veränderte H-Balken, also Bestandteile des Buchstaben H, ausgetauscht, und manchmal werden auch einzelne Buchstaben durch Runen, oder, um den Zugriff noch einmal zu erschweren, durch Phantasiezeichen ersetzt.“

Selbst ganze Wörter, die besonders wichtige Personen, wie König, Kaiser oder Papst kaschieren sollten, wurden oft chiffriert. Dabei wählte man zum Verbergen brisanter Informationen gerne Vertrautes aus dem Alltag. In den venezianischen Gesandtschaftsberichten, ersetzte man z.B. heikle Schlüsselwörter durch Begriffe von Handelswaren. „Da findet man dann sehr viele Fische und Früchte, wohingegen man in risikobehafteten Schreiben aus dem kirchlichen Bereich zuweilen Brisantes mit Vokabeln aus dem klösterlichen Leben verschleierte.“

In den sehr elaborierten Mailänder Schreiben des 15. Jahrhunderts, mit denen sich die Historikerin befasst, wusste man auch weitere Einbruchstellen auszumerzen; ersetzt wurde dabei ausschließlich durch Phantasiezeichen. Man glich die Buchstabenhäufigkeit durch den Einsatz mehrerer Alphabete, bestehend aus abstrakten Zeichen, aus. Gerade für die Vokale, die am häufigsten vorkommen, gab es bis zu vier Zeichen.

Man verzichtete auf eine Worttrennung, manchmal verschmolz man auch den letzten Buchstaben eines Wortes mit dem ersten des Folgewortes. Ferner verbarg man häufig im Text vorkommende Wörter, insbesondere Konjunktionen und Präpositionen sowie Schlüsselwörter, wie Krieg oder Frieden, aber auch zentrale Akteure und Orte durch jeweils ein Phantasiezeichen. Klassische Einbruchstellen für Decodierungen seien überdies sogenannte qu-Kombinationen, denn auf den Buchstaben „q“ folge in der Regel immer ein „u“, daher wurde auch die qu-Kombinationen eliminiert und durch geheime Zeichen ersetzt. Und auch sinnentleerte Zeichen wurden in den Text zur Verwirrung des unbefugten Lesers eingestreut sowie absichtliche Schreibfehler zu diesem Zweck eingebaut.

„Es ist eine Kombination aus einer polyalphabetischen Chiffrierung und einer langen Liste mit codierten Schlüsselwörtern bestehend aus Phantasiezeichen, die die mentale Hürde zusätzlich hochschrauben, gepaart mit sinnentleerten Zeichen. Und jeder Adressat hat einen anderen Schlüssel. Wenn ich also als Historikerin den jeweiligen Schlüssel dafür nicht habe, bin ich verloren“, sagt sie.

Das Voynich-Manuskript, ein nicht zu lösendes Rätsel?

Im selben Jahrhundert wie die Mailänder Geheimschriften entstand das bis heute meistdiskutierte Objekt in der historischen Kryptographie, das so genannte Voynich-Manuskript, an dem sich Historiker bis heute die Zähne ausbeißen. „Das ist sehr spannend“, berichtet die Wissenschaftlerin begeistert, „weil es ein äußerst geheimnisvolles Manuskript ist. Der Name stammt von Wilfrid Michael Voynich, der es 1912 erworben hat. Das Manuskript ist deshalb so berühmt, weil es in einer Schrift verfasst ist, die man bis heute nicht hat entschlüsseln können. Es ist mit vielen nachträglich kolorierten, teils sehr bizarren Abbildungen versehen worden, die ebenfalls viele Fragen aufwerfen, und weil man mit dem Text nicht so leicht arbeiten kann, hat man, entsprechend der Abbildungen, dieses Manuskript in verschiedene Sektionen eingeteilt.“

Diese beschäftigen sich unter anderem mit Kräuterkunde, Anatomie, dem Kosmos und der Pharmazie. Und obwohl das Manuskript sogar einen Schlüssel nennt, habe dieser bis heute nicht zur Dechiffrierung beigetragen. Zwar gebe es viele Spekulationen, aber das Rätsel konnte bis heute nicht gelöst werden.

Ein Jahrtausende altes Katz- und Mausspiel

Geheimschriften wurden bis in die Gegenwart immer wieder aus politischen Gründen zu taktischen Zwecken genutzt, so auch im Ersten und Zweiten Weltkrieg. Dank des Kinofilms „The Imitation Game“ aus dem Jahre 2014, der die Rotor-Schlüsselmaschine der Deutschen Wehrmacht mit dem Namen „Enigma“, die durch den Engländer Alan Turings geknackt wurde, in den Fokus stellte, interessieren sich wieder zahlreiche Menschen für dieses Thema. Die „Enigma“ war nur eine von vielen Rotor-Chiffriermaschinen, die man heute im Deutschen Spionagemuseum in Berlin bewundern kann.

Prof. Dr.-Ing. Tibor Jager, Leiter der Abteilung IT Security and Cryptography der Fakultät Elektrotechnik, Informationstechnik und Medientechnik, der kryptographische Verfahren entwickelt, die die Sicherheit und Privatsphäre in modernen Anwendungen effektiv schützen können, sagt: „Man muss erst einmal sagen, es war gar nicht nur Turing, sondern vor allem polnische Kryptoanalytiker wie zum Beispiel Marian Rejewski und auch noch ein paar andere Wissenschaftler, die die entscheidende Vorarbeit geleistet, ziemlich zentrale Ideen gehabt haben und meist nicht genannt werden. Denen hat aber dann vor allem die Rechenleistung gefehlt. Sie haben sich mit den Briten zusammengetan, die dann Maschinen, die sogenannten Bombas bauten – die haben getickt wie eine Bombe.“

Die „Enigma“ gleiche einer alten Schreibmaschine, sagt Jager und fährt fort: „Die Idee dahinter war, dass es anstatt von Ärmchen, die normalerweise Buchstaben auf Papier drücken, Walzen gab, so dass jedes Mal, wenn man eine Taste für einen Buchstaben drückt, ein Lämpchen aufleuchtet. Jedes Lämpchen entspricht wiederum auch einem Buchstaben. Also ich drücke zum Beispiel ein ,A‘ und es leuchtet ein ,W‘ auf, und welcher Buchstabe in welchen anderen Buchstaben verschlüsselt wird, das wird durch den Stand der Walzen bestimmt. So weiß ich, wie ich verschlüssele. Die unter der Tastatur befindlichen Walzen funktionieren ähnlich wie ein Kilometerzähler bei den früheren Autos. Man hat ein Rädchen, was sich bei jedem Tastendruck einen Schritt weiterdreht und wenn eine Umdrehung beendet ist, springt das nächste Rädchen um, und ich bin wieder eine Stufe weiter. Wenn man also dann wieder ,A‘ drückt, dann wird dieses dann in einen anderen Buchstaben als zuvor verschlüsselt, zum Beispiel in ein ,D‘“.

Variationen dieser Maschine existieren mit verschiedenen Walzen und es ergebe sich daraus jedes Mal, wenn sich ein Rädchen drehe, ein neuer Buchstabe. Weitere Steckverbindungen, die Teil des Schlüssels waren, erschwerten zusätzlich die Dechiffrierung, so dass die Kombinationen schier unendlich seien. „An dieser Stelle kommt dann die Genialität dieser polnischen Mathematiker ins Spiel. Die haben nämlich verstanden, das sind alles Permutationen, also Anordnungen von Objekten in einer bestimmten Reihenfolge. Sie haben in mathematische Theorien zu Permutationen geschaut und erkannt, dass man die in Zyklen zerlegen kann und das als Hebel benutzt, um diesen riesigen Schlüsselraum nach und nach einzuschränken. Mit den dazu geschaffenen Maschinen konnte man diese riesige Schlüsselmenge dann automatisiert durchsuchen.“ Von 1940 bis Kriegsende konnten so zweieinhalb Millionen Funksprüche abgefangen und entziffert werden.

Die Erfindung der beweisbaren Sicherheit

Viel hat sich seit der Cäsar-Chiffre getan, doch der beeindruckendste Fortschritt gelang erst 1984. „Das ist noch gar nicht so lange her“, sagt Jager, „dann wurde die sogenannte beweisbare Sicherheit erfunden. Manche Leute sagen, das war der Zeitpunkt, wo die Kunst der Verschlüsselung zur Wissenschaft der Verschlüsselung geworden ist. Seitdem können wir besonders gute und mathematisch beweisbar sichere und praktische Chiffren bauen.“

Dr.-Ing. Kai Gellert, Mitarbeiter im Team Jager, bietet unter dem Blickwinkel der 1984er Erkenntnisse regelmäßig Veranstaltungen unter dem Titel „Moderne Kryptographie“ an. Sichere Chiffren sind z.B. für jeden Bürger im Bereich Onlinebanking wichtig. Neben der Vertraulichkeit habe man da aber auch noch andere Anforderungen, weiß Jager und sagt: „Wenn ich jemandem 10 Euro überweise, möchte ich nicht, dass jemand auf einmal daraus 100 Euro macht.“ Im Zuge der Digitalisierung werden kryptographische Techniken auch im Internet immer wichtiger, die abgesehen vom Bankgeheimnis den Nutzer auch schützen sollen, denn Fälle, in denen mein Suchverhalten dort auch ausgenutzt werden kann, hat es bereits gegeben.

Jager nennt ein prominentes Beispiel. „Es gibt zum Beispiel Berichte darüber, dass die Firma Cambridge Analytica das Verhalten von Internet-Nutzern analysiert hat, um so ihr Wahlverhalten in US-Wahlen und im Brexit-Votum gezielt zu manipulieren. Solche Methoden werden möglich, weil wir digital miteinander kommunizieren. Auch da kann Kryptographie helfen.“

Moderne Verschlüsselungsverfahren = neue Geheimschriften

„Es gibt natürlich neue Geheimschriften. Das sind z.B. die heutigen modernen Verschlüsselungsverfahren, die ganzen kryptographischen Verfahren, die noch immer auf teilweise ähnlichen Prinzipien basieren, aber mathematisch wesentlich besser verstanden sind“, erklärt Gellert. Auf der Grundlage des ursprünglichen Verfahrens symmetrischer Verschlüsselungen, die vom Sender chiffriert und vom Empfänger dechiffriert werden konnten, weil beide den gleichen Schlüssel besaßen, haben sich im Computerzeitalter mittlerweile komplizierte Methoden entwickelt, die man auch fachlich versierten Studierenden lange erklären muss.

Es eröffne sich dort eine ganz neue Welt, schwärmt Gellert, die kontinuierlich auch immer Gefahren einkalkulieren und abwehren muss. „Man hört in den Medien, dass Quantencomputer immer realistischer werden, die eine Gefahr für bestimmte mathematische Probleme sind, auf denen unsere Verfahren basieren“, sagt Gellert. Daher suche man aktuell nach Verfahren, die standardisiert werden sollen, um sich vor diesen Computerangriffen zu schützen. Ein erster bahnbrechender Erfolg könnte daher ein jüngst erfolgter Beschluss der amerikanischen Standardisierungsbehörde dazu sein.

Dazu Gellert: „Vor kurzem wurden von der amerikanischen Standardisierungsbehörde (National Institute of Standards and Technology, kurz NIST genannt) die ersten Verfahren ausgewählt, die nach jahrelangen Diskussionen jetzt standardisiert werden sollen. Damit können wir die Sicherheit unserer Daten auch in der Zukunft gewährleisten.“

History meets Computer Science

Um die Herangehensweise kryptographischer Geschichtsforschung und die Anwendung sicherer kryptographischer Verfahren der Informatik zu verstehen, bedurfte es zunächst einiger Gespräche, in denen die sehr unterschiedlichen Fächer ihre Arbeitsweise erläuterten, denn die moderne Cryptocommunity hat einen ganz anderen Ansatz, forscht mit anderen Mitteln und auch anderer Literatur.

„Da spielt auch eine technische Komponente mit rein“, sagt Gellert, „denn damals wurde noch mit der Hand verschlüsselt. Das waren also Briefe, die in den Archiven schwer zugänglich sind. Mit dem Zweiten Weltkrieg kommen nun diese Chiffriermaschinen dazu, man konnte Funk abhören und es kommen mehr Materialien zu einem Thema zusammen, die auch leichter verfügbar sind“, und Jager ergänzt: „Zudem gelten in der modernen Wissenschaft diese alten Schriften als unsicher und sind daher auch nicht so interessant.“

Das große Problem bei alten Stücken sei die Art der Lagerung. In diversen Kisten in endlosen Regalreihen liegen diverse Dokumente in den Archiven, die man händisch sichten müsse. Diese seien nicht digitalisiert und somit nur sehr zeitaufwändig einsehbar, weiß Jager. „An dieser Stelle wird es nun wieder für uns Informatiker interessant, denn es stellt sich nicht so sehr die Frage, wie man das knacken kann, sondern wie kann man das im großen Stil automatisiert knacken, also ohne diese Fleißarbeit? Da wird es für uns wieder algorithmisch interessant, weil man nun dem Computer beibringen kann, diese Sachen zu entschlüsseln. Was wir immer brauchen, ist eine informatikerlesbare Darstellung.“

Ist diese Voraussetzung gegeben, erklärt Jonas von der Heyden, „ist es interessant, Algorithmen zu entwickeln, mit denen man dann verschlüsselte Dokumente automatisiert untersuchen und entschlüsseln kann. Dazu brauchen wir dann die Historiker, die die Ergebnisse auf Plausibilität prüfen und auch Symbole erläutern, die man dann ins Programm eingeben kann.“

An dieser Stelle kommt das dritte Fach „Digital Humanities“ unter Leitung von Prof. Dr. Patrick Sahle ins Spiel. Er fungiert sozusagen als Mittler zwischen der Geschichte und der Informatik, er weiß, wie diese historischen Dokumente in die Digitalisierung überführt werden können.

Authentizität der Dokumente muss gewahrt bleiben

Die Aufbereitung historisch chiffrierter Dokumente für die moderne Forschung ist nach Sahles Meinung schon weitgehend standardisierte Praxis. „Schwieriger wird es aber in kleineren Archiven oder solchen, die keine eigene Digitalisierungsabteilung haben“, erklärt der Fachmann. „Dazu gibt es aber ,semiprofessionelle‘ Ausstattungen, mit denen man als Benutzer Digitalisate, wenn es die Archive erlauben, anfertigen kann.“

Ist das nicht der Fall, müsse man leider auf einfache Handyfotos, Fotokopien oder z.B. die Mikrofilme zurückgreifen, die es in Archiven schon gebe. Zu den Digitalisaten brauche man Beschreibungen in Form von „Metadaten“, und auch da gebe es eine etablierte Praxis, an die man sich halten könne. Digitale Editionen werden mittlerweile sowohl in Form von Faksimiles, also Bildern, als auch in Transkriptionen publiziert. „Dabei können die Transkriptionen auch mehrfach normalisiert, reguliert, modernisiert oder in ein anderes Schriftsystem übertragen werden und erlauben somit eine quellen- oder benutzernähere Verwendung.“

Die kulturgeschichtliche Dimension und die Authentizität der Dokumente dürfe natürlich nicht verloren gehen, erklärt Sahle. „Für die Transparenz und Nachprüfbarkeit der Verarbeitung und Entschlüsselung würde man gerne die chiffrierten Texte auch in den Chiffren selbst wiedergeben. Einen entsprechenden Font (Schriftart) zu kreieren, ist kein Hexenwerk und ,mittel aufwändig‘.“

Da es sehr viele Chiffrierschlüssel und stark abweichende Zeichensysteme gebe, sei vor allem zu prüfen, wie weit solche Prozesse automatisiert werden könnten. „Wir prüfen dazu mit Kollegen in Erlangen Bilderkennungsalgorithmen, die selbstständig die vorkommenden Zeichen identifizieren und clustern können. Der nächste Schritt wäre dann eine automatische Font-Generierung. Das erfordert aber noch einigen Entwicklungsaufwand und wird wahrscheinlich auch dann nicht ganz ohne menschlichen Eingriff ablaufen können.“

Bis es soweit ist, dass man flächendeckend alte Manuskripte in den Archiven über Computerprogramme algorithmisch auswerten kann, werden Historikerinnen wie Dr. Jessika Nowak noch lange in akribischer Fleißarbeit verschlüsselte Dokumente und Briefe über Intrigen, Liebe, Macht und Herrschaft beforschen und sich auch über kleine Entschlüsselungen riesig freuen.